Inteligencia artificial: reemplazo, hibridación… ¿progreso?

Nueva Sociedad 307 / Septiembre - Octubre 2023

El salto en la adopción de inteligencia artificial que significó el lanzamiento de ChatGTP invita a reflexionar no solo sobre cómo se usa esta tecnología, sino también acerca de quién y cómo se produce la IA y quiénes se benefician de ella. ¿Qué tipos de trabajo permiten producirla? ¿Cuáles son las consecuencias de su adopción en términos de reemplazo de capacidades de aprendizaje? ¿Es posible otro modelo de inteligencia artificial?

En noviembre de 2022, Openai lanzó Chatgpt. Según la compañía, en solo cinco días la aplicación ya tenía un millón de cuentas activas. A Instagram, hasta entonces un ejemplo de rápida adopción, le había llevado aproximadamente dos meses y medio llegar a ese número de descargas. Para enero de 2023, Chatgpt tenía más de 100 millones de cuentas activas1. Se trata de una tecnología de fácil y barata adopción. Su uso no requiere equipamiento sofisticado porque corre en internet, y Chatgpt incluso tiene una versión gratuita. También hay modelos rivales menos avanzados disponibles en acceso abierto, aunque su uso requiere de adaptación. Como veremos a continuación, la posibilidad de ofrecer tecnología de frontera a bajo precio se explica, entre otros factores, porque su base es la apropiación de conocimiento y datos producidos por terceros.

En este escenario, la preocupación ya no por el futuro, sino por el presente del trabajo, creció exponencialmente. El futuro del trabajo es hoy; millones de tareas se están automatizando. McKinsey, la consultora privada más grande del mundo, estima que, para 2030, 30% de las tareas que hoy se realizan en Estados Unidos estarán automatizadas2, una cifra que esconde las desigualdades del mercado laboral. En el mismo informe, se calcula que quienes realizan los trabajos peor pagos tienen hasta 14 veces más posibilidades de tener que cambiar de empleo que quienes cobran los salarios más altos, en tanto que las mujeres tienen 1,5 veces más probabilidades de tener que buscar otro empleo que los varones3.

Entender por qué la inteligencia artificial (ia) que se desarrolla en la actualidad prioriza la automatización requiere sacar el zoom de las discusiones acerca del uso de esta tecnología para centrarnos primero en las relaciones de producción de ia. Iremos del trabajo que produce ia a la ia que reemplaza trabajo. Esto implica preguntarnos qué se está produciendo, es decir, qué es la ia.

¿Qué es la inteligencia artificial y quién la controla?

Yendo del género a la especie, la ia se compone de un conjunto de algoritmos, es decir, reglas o instrucciones que deben seguirse para resolver un problema o realizar un cálculo. Aunque usamos algoritmos para resolver problemas de lo más diversos, su popularidad reciente está asociada al big data. Los grandes volúmenes de datos extraídos de plataformas digitales o de otros ámbitos, tales como máquinas conectadas a través de la internet de las cosas, deben procesarse para obtener información –sobre el pasado y el presente– que pueda configurar el futuro. Para ello se usan algoritmos.

En la actualidad, la técnica más avanzada para procesar datos es un subconjunto de algoritmos de ia, una clase de machine learning llamada aprendizaje profundo (deep learning) o redes neuronales profundas (deep neural networks). Esta es la tecnología de ia que más creció en solicitudes de patentes entre 2012 y 20164, y su desempeño es mejor que el de cualquier otro modelo de ia5. Los modelos de deep learning están constituidos por muchas capas que forman redes jerárquicas para aprender características y clasificar identificando patrones.

La especificidad de estos algoritmos es que evolucionan, se vuelven más expertos en función de la afluencia y el análisis de datos. En otras palabras, aprenden y mejoran por sí mismos a medida que procesan más datos, ajustando sus parámetros para arrojar mejores previsiones. Por eso la escala es importante para el desarrollo y el uso de la ia. Datos y algoritmos son complementarios estrictos e igualmente indispensables para que la ia funcione. En la medida en que estos modelos se vuelven mejores con el uso, podemos pensarlos como medios de producción que se aprecian con el tiempo, lo cual los hace únicos, ya que el resto de los medios de producción se deprecian con el uso.

Es tan variada su aplicación que se ha comenzado a hablar de la ia como una tecnología de propósito general, o incluso de un nuevo método para inventar, en la medida en que permite automatizar descubrimientos y expandir el tipo de problemas que se pueden estudiar con big data6. En última instancia, el objetivo de las grandes empresas que están detrás de estos modelos es producir una tecnología que no necesite procesos de adaptación, que pueda ser adoptada directamente para los entornos más diversos. Ergo, que sus clientes sean potencialmente todas las organizaciones y personas del mundo.

En esa búsqueda, aparece un tipo específico de modelo de deep learning, los large language models (llm, modelos de lenguaje de gran escala). Chatgpt está basado en el llm más grande del mundo. Los llm predicen qué palabra viene a continuación en una secuencia. Como explica Google, «los llm generan nuevas combinaciones de texto en forma de lenguaje natural. E incluso podemos construir modelos lingüísticos para generar otros tipos de resultados, como nuevas imágenes, audio y también video»7. En una entrevista, un empleado de Google los definió como «agénticos» porque el agente inteligente –el programa informático– interactúa con el entorno y aprende a actuar en él8.

Es una herramienta poderosa porque, como todo modelo de deep learning, los llm mejoran cuantos más datos procesan, con lo que en cierta medida se externaliza parte de su mejora a usuarios o clientes. Es decir, parte del trabajo que produce la ia –que no es remunerado– es realizado por quienes la consumen. Por ejemplo, cada vez que le hacemos una pregunta o pedimos algo a Chatgpt, se producen más datos que pueden ser usados para mejorarlo.

Una abogada de Amazon llegó a decir que nadie en la compañía debía proporcionarle «información confidencial de Amazon a Chatgpt (incluido el código de Amazon en el que estés trabajando)» y añadió que esta recomendación era «importante porque tus entradas pueden utilizarse como datos de entrenamiento para una iteración posterior de Chatgpt, y no querríamos que su resultado incluyera o se pareciera a nuestra información confidencial (y ya he visto casos en los que su resultado se parece mucho al material existente)»9. Amazon no es la única empresa líder que prohibió o limitó el uso de Chatgpt a sus empleados por estos motivos: Apple, jpmorgan Chase y Samsung siguieron sus pasos10. ¿Es solo Openai, la empresa creadora de Chatgpt, lo que las preocupa?

¿Otra vez sopa?

En mayo de 2023, el canal de televisión cnbc entrevistó al ceo de Microsoft Satya Nadella. Cuando le preguntaron si la actual ola de ia favorecía a las empresas establecidas, respondió negativamente, sin miramientos, aduciendo que una start-up, Openai, lideraba esta tecnología11. Lo que Nadella omitió es que su empresa es dueña de 49% de Openai y que está bajo su órbita al menos desde 2019, cuando le otorgó un primer financiamiento de 1.000 millones de dólares a cambio de acceso exclusivo al llm que Openai estaba desarrollando por entonces (gpt-3). El acuerdo significó para Microsoft la posibilidad de orientar los desarrollos y definir las prioridades de Openai. Microsoft la instó a priorizar el desarrollo de una interfaz para utilizar gpt-3, luego llamada Chatgpt, a la cual Microsoft tuvo acceso mucho antes del lanzamiento público, con la posibilidad de integrar la tecnología a sus servicios de la nube, incluido su motor de búsqueda Bing. Openai no solo consiguió financiamiento, que luego del éxito de Chatgpt Microsoft incrementó en 10.000 millones de dólares adicionales12. Pasar a integrar el séquito de empresas que dependen de Microsoft incluyó acceso a su nube pública, algo indispensable para entrenar los llm de Openai, los más grandes que jamás se hayan visto13.

La empresa DeepMind, adquirida por Google en 2014, venía trabajando en la frontera de los llm desde hacía años, pero sin que ello redundara en lanzar un producto semejante a Chatgpt. Temiendo que Bing pudiera avanzar sobre el poder de mercado de su motor de búsqueda, Google reaccionó precipitadamente lanzando su propio gran modelo lingüístico, Bard, que cometió un error en su primera demo. En febrero de 2023, Meta presentó su propia alternativa, llama (Large Language Model Meta ai)14. Amazon entró en la carrera ampliando su apoyo a Hugging Face, una start-up cuyo chatbot de ia se ofrece como servicio en la nube de Amazon, y ofreciendo Amazon Bedrock, un servicio para crear y escalar aplicaciones de ia basadas en llm15. En una saga digna de un documental de Netflix, en menos de un año vimos desfilar nuevas versiones y servicios en la nube que, en última instancia, son similares a Chatgpt. Otra similitud es que todos estos llm están bajo el control –directo o indirecto– de unas pocas grandes empresas de tecnología digital.

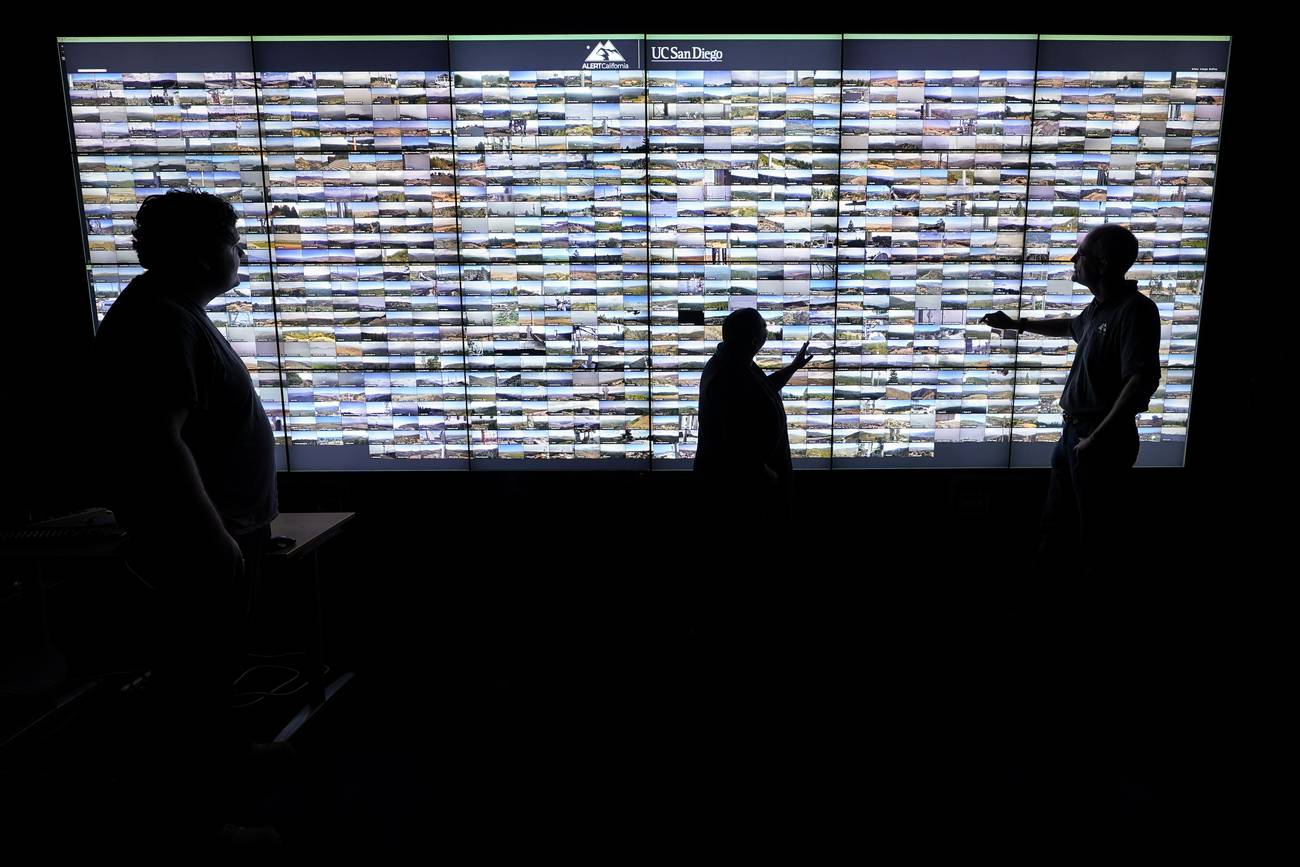

El mismo pequeño grupo de gigantes no solo monopoliza el desarrollo de la ia más avanzada, sino también las mayores bases de datos, que están en continua expansión a medida que usamos sus plataformas y la infraestructura digital –procesadores y servidores interconectados en centros de datos de superficie mayor a un estadio de fútbol–. Hasta la Harvard Business Review, una revista para ejecutivos, ya había publicado un artículo que llamaba la atención acerca del excesivo poder de las denominadas big tech años antes de la llegada de Chatgpt16.

La capacidad de control de la ia por parte de unas pocas firmas de tal envergadura no tiene precedentes. Me refiero aquí, en particular, a Amazon, Google, Meta y Microsoft, aunque Alibaba, Tencent y otros gigantes chinos, como la empresa dueña de TikTok, también desarrollan y utilizan ia apropiándose de código y datos a mansalva. En un artículo reciente, construí un proxy de la red de organizaciones que más trabajos presentaron en las conferencias de ia más importantes del mundo. Todos estos gigantes digitales integran la red, con Google y Microsoft en las posiciones más importantes. Es más, Microsoft es el puente que conecta las organizaciones occidentales con las chinas, una clara señal de su papel geopolítico estratégico17. Microsoft es el único gigante estadounidense bien posicionado en China, donde abrió su primer gran campus de i+d fuera de eeuu en 2010. Esta presencia también se ha traducido en colaboraciones regulares para el desarrollo de ia con las principales universidades de ese país y con sus gigantes digitales. Microsoft conecta todo el campo de la ia y se beneficia de la investigación en ia más avanzada en tanto es ella –y las otras grandes firmas digitales–, y no las universidades y otros organismos de investigación con los que coproducen ia, quienes monetizan el conocimiento coproducido18.

Huelga decir que las grandes empresas de tecnología de eeuu también ocupan un lugar destacado en los comités de las conferencias que, en última instancia, definen qué trabajos son de frontera y merecen presentarse. Por ejemplo, todas tienen al menos un miembro en el comité organizador de Neurips, la principal conferencia anual sobre machine learning. Google, que obtuvo el mayor número de trabajos aceptados en esta conferencia en 202219, contó con nueve de sus 39 miembros.

Este puñado de empresas controla todo el sector. Google ha adquirido más start-ups de ia que cualquier otra empresa del mundo, y las otras gigantes no se quedan atrás. Otro mecanismo que utilizan para controlar y acceder al código desarrollado por otras empresas es oficiar de inversoras de capital de riesgo. El ejemplo de Openai financiada por Microsoft al cual aludí más arriba es quizás el más exitoso. Un tercer mecanismo de apropiación de ia, usado en particular por Microsoft, Google y Meta, es poner en acceso abierto un código que no pone en riesgo su poderío tecnológico. Al contrario, al abrirlo a la comunidad, promueven su uso y mejora. Ese código luego se integra con más código y otros conocimientos guardados en secreto, lo que permite que todo el modelo se optimice y resulte en mejores servicios digitales. Bajo la apariencia de contribuir al desarrollo de software libre, tercerizan parte del trabajo de desarrollo sin poner en riesgo –de hecho, más bien potenciando– su liderazgo.

El resultado son sistemas de innovación integrados por múltiples organizaciones en los cuales la empresa líder que planifica el sistema se beneficia desproporcionadamente. Estos sistemas corporativos son un fenómeno mucho más extendido. Se trata de una nueva forma de capitalismo, en la que una empresa es poderosa no en función del tamaño de sus fábricas, sino de su capacidad para apropiarse de intangibles –conocimiento e información– que utiliza para adueñarse del valor de terceros20. En estas redes, las grandes empresas de tecnología digital se sitúan en la cúspide del poder corporativo porque han acaparado el paquete tecnológico que está transformando todos y cada uno de los ámbitos de la vida. Su apropiación de ia de frontera –junto con los datos que le dan vida– reconfigura regresivamente al capitalismo. Justamente por sus efectos en materia de una todavía mayor polarización y desigualdad, es especialmente relevante profundizar en el trabajo que produce y el que es reemplazado por ia.

Hibridación

En su racconto de la prehistoria de la nube pública, Tung-Hui Hu dice que nuestra imaginación de una «nube» virtual desplaza al trabajo. En otras palabras, entre tantos intangibles –plataformas, la nube, internet, etc.– se invisibiliza el trabajo productor de servicios digitales21. La ceguera es aún mayor en el caso de la ia, pues frecuentemente se la presenta como alternativa en lugar de complemento del trabajo. Pero la ia es producto del trabajo, y su supervivencia –como expliqué más arriba– depende del continuo trabajo consuntivo que hagamos de ella. La frontera entre producción y consumo de ia se disipa, y con ello se pierde nitidez en la distinción entre el trabajo que produce ia y el producto de ese trabajo.

Los «sabios» de la era digital

Como afirmó un ejecutivo y científico de ia de Amazon, lo más importante para ser líder en ia es contar con las personas con más talento22. Según un científico de ia de bosch, las big tech estadounidenses lideran la ia precisamente porque contratan a las personas con más talento, e impiden a la vez que sus rivales accedan a ellas23. Una gerente de recursos humanos de Alibaba me confirmó que el grueso del talento internacional trabaja para Amazon, Microsoft y Google24. A menudo, estas empresas se llevan a los científicos y científicas más prometedores del mundo académico. Distintos entrevistados me mencionaron que las conferencias sobre ia son usadas por las gigantes de tecnología para identificar y captar talentos. Al reconstruir el historial de afiliación de más de 60.000 investigadores de ia, Roman Jurowetzki et al. descubrieron que 8% había pasado del mundo académico a la industria y que este drenaje se profundizó desde 201025. En una línea similar, Michael Gofman y Zhao Jin encontraron niveles elevados y exponencialmente crecientes de profesores de ia de universidades estadounidenses y canadienses que pasaron a la industria26. Las empresas que más contrataron fueron Google, Amazon y Microsoft.

Otra práctica frecuente es contratar a académicos destacados a tiempo parcial, que mantienen sus puestos universitarios. Estos ofician, queriéndolo o no, de puente entre la coproducción de ia con el mundo académico y la apropiación de resultados por parte de sus empleadoras privadas. En mi muestra de ponencias de conferencias sobre ia encontré alrededor de 100 universidades que cuentan con al menos una persona con doble afiliación con una gran empresa de eeuu. Google y Microsoft son las que más utilizaron esta táctica27.

El menor número de dobles dependencias entre Amazon y universidades no es sinónimo de un menor interés en controlar la disciplina. Por el contrario, subyace una táctica diferente, que igualmente busca direccionar y aprovechar de manera privada las capacidades de los principales talentos en ia. Mis entrevistados coincidieron en que Amazon privilegia las presentaciones internas en las que académicos de alto nivel, contratados como consultores, describen lo que están haciendo en su universidad o, tras firmar estrictos acuerdos de confidencialidad, asesoran a investigadores de Amazon.

Si bien no encontré dobles dependencias con países periféricos, ello no implica que estemos frente a otro episodio en el cual estos países se limitan a adoptar la tecnología producida por los centrales, un tema que ha sido ampliamente estudiado por la teoría de la dependencia en el pasado y que en la actualidad adquiere ribetes un tanto diferentes. En la era digital, la producción de algoritmos y datos está globalizada. Sin embargo, estos intangibles son transformados en activos y reportan rentas de manera desproporcionada a las megaempresas de tecnología de las dos principales potencias del siglo xxi: eeuu y China. Investigadores de universidades líderes de países periféricos participan en las conferencias más importantes de ia del mundo. La Universidad de San Pablo es la primera de América Latina en cantidad de presentaciones en el periodo más reciente que analicé. A tal punto produce conocimiento de frontera que comparte un centro de investigación en ia con ibm (c4ai). El director es un investigador de la universidad brasileña, mientras que el codirector es un investigador de ibm. De momento, sus resultados son solo académicos, pero esa colaboración permite a ibm un acceso privilegiado a conocimiento que luego puede utilizar para desarrollar servicios digitales.

Microtareas

La ia no se produce solamente escribiendo el código. Me referí previamente a la necesidad de entrenar los modelos con bases de big data. Estas bases de datos tienen que ser puestas a punto, pero para ello hay que construirlas. Detrás de cada botón o funcionalidad en una plataforma digital, está el trabajo de pensar los tipos de datos que pueden ser necesarios y cómo recolectarlos. Además, el proceso de producción de bases de datos usa, en general, trabajo impago. Un precedente conocido es recaptcha de Google, el sistema utilizado para validar que no somos robots, que simultáneamente terceriza la clasificación de imágenes que luego son usadas para entrenar modelos de ia. Esto ha dado lugar a varios escándalos en el proceso de producción de bases de datos, que incluyen casos en los que algunas personas descubrieron que sus fotos habían sido utilizadas –sin permiso– para entrenar algoritmos de ia28. Una actriz que trabaja subcontratada por una empresa de doblaje que, a su vez, es contratista de Disney, me contó de un caso reciente en el cual un actor de doblaje fue convocado por un estudio para realizar una grabación, sin que supiera que su voz sería utilizada para entrenar ia para doblajes.

Las bases que surgen de datos que creamos colectivamente en las plataformas también requieren trabajo para ser utilizadas como material de entrenamiento. El big data es el producto de miles de microtareas de limpieza y clasificación de cada entrada que van más allá de recaptcha. Se las llama microtareas porque se paga por entrada limpia y clasificada. Este microtrabajo a destajo se ofrece en plataformas especializadas, una de ellas propiedad de Amazon, por las cuales se pagan centavos por entrada a miles de trabajadores repartidos por el mundo –sobre todo, de países periféricos–. La Organización Internacional del Trabajo (oit) realizó un estudio comparativo que relevó las condiciones laborales de 3.500 personas residentes en 75 países que realizan microtareas. Encontraron que el ingreso promedio por hora era de 3,31 dólares, aunque este valor esconde fuertes heterogeneidades geográficas. En África (1,33 dólares por hora) o Asia-Pacífico (2,22 dólares por hora) se gana mucho menos que en las regiones centrales. En su mayoría, las personas entrevistadas señalaron que quisieran trabajar más horas, pero no encontraban suficientes microtareas disponibles29.

Una vez que se tienen las bases y el modelo está desarrollado, su uso no está aún completamente automatizado. Más allá de las tareas de mantenimiento, ejércitos de trabajadores y trabajadoras filtran y promueven contenido en las plataformas digitales en conjunto con la ia. En general, los algoritmos realizan un primer filtro de contenido que luego es controlado por personas.

Esta tarea está en ocasiones tercerizada, como en el caso de la empresa Meta, aunque otras empresas contratan trabajadores directamente para ello, como ByteDance, la dueña de TikTok. Cualquiera sea el caso, filtrar contenido puede generar traumas, consecuencias psicológicas y estrés debido a la sobreexposición a violencia que va desde asesinatos en vivo hasta fotos de pedofilia. Quienes filtran contenido para Meta ganan casi 8,5 veces menos que el promedio de los empleados de la compañía, y las condiciones de trabajo de los moderadores de contenidos distan mucho del ambiente relajado de las instalaciones de la empresa creadora de Facebook30. Una persona que realiza esta tarea en Europa me contó que actualmente están entrenando una ia que podría eventualmente reemplazarlos, aunque agregó que en verdad el reemplazo ya está ocurriendo, pero por trabajadores que ganan menos en oficinas de la misma empresa tercerizada de Facebook en países periféricos, entre ellos en América Latina31. Estas tareas tercerizadas operan siguiendo minuciosamente los requerimientos de la empresa de Mark Zuckerberg bajo estrictos contratos de confidencialidad.

Una tarea algo diferente, pero que igualmente muestra la convivencia o hibridación entre la ia y las personas, es la promoción de contenido en TikTok. Cada empleado del área de «Push» (empujar en inglés) recibe 14.000 videos por semana que ya rankean alto en vistas. Su tarea es evaluarlos para definir si TikTok va a «empujar» ese video para que tenga más visualizaciones, con el objetivo final de que los usuarios pasen más tiempo en la plataforma. Un video «empujado» se muestra con mayor frecuencia en las pantallas de usuarios identificados de manera automática como potencialmente interesados. Aunque la ia podría hacer todo el proceso sola, ByteDance elige incluir una etapa de control humano en la cual se decide promover contenido que se ajuste a protocolos definidos por gerentes de la empresa, para asegurar que TikTok siga siendo vista como una plataforma de videos caseros aptos para todo público. Como me dijo la persona que entrevisté, «yo trabajo en la cocina de TikTok»32.

Reemplazo

Aunque la ia sea producida por decenas de miles de personas, en trabajos que van desde los más sofisticados y que expanden la frontera del conocimiento a tareas rutinarias y hasta traumáticas, al mismo tiempo muchas tareas que en otras industrias antes eran realizadas por seres humanos ya han sido o están siendo reemplazadas por algoritmos.

Los análisis sobre el reemplazo de trabajo por máquinas usualmente se centran en previsiones acerca de cuántas y cuáles tareas pueden ser automatizadas33. Antes de la difusión de los llm, las tareas que podía reemplazar cada ia eran limitadas. El modelo de ia que define precios en una plataforma de comercio electrónico –como Amazon o Mercado Libre– o el algoritmo de ia que busca links cuando hacemos una búsqueda en Google no son comparables en materia de potenciales aplicaciones con Chatgpt. De allí que su rápida adopción genere mayores preocupaciones.

De momento, se observan grados muy variados de uso de esta tecnología según cómo perciba cada empresa los riesgos y costos asociados, por ejemplo, el mantenimiento de servidores, la migración a la nube y el uso mismo de la ia. Si bien hay llm de acceso abierto o de uso gratuito, no se trata de los modelos más avanzados. Estos últimos se mantienen en secreto y se vende su uso –sin acceso al código– como un servicio en la nube. Los modelos en acceso abierto igualmente requieren mantenimiento y adaptación a los problemas específicos de cada negocio. Es decir, requieren trabajo. Entre las empresas que he entrevistado, si bien algunas ya utilizan llm disponibles en las nubes de las big tech para tareas puntuales, como optimizar presentaciones, realizar traducciones o redactar contenido para las redes sociales, otras son más escépticas. La gerenta de finanzas de una multinacional productora de hardware con sede central en eeuu lo resumió de la siguiente manera:

Estamos recién en el principio, aunque la ai se masificó, pero también te preguntas para qué. Cuando yo hice todo mi research de Chatgpt, me pregunté: ¿cuáles son realmente las cosas que podemos implementar en un trabajo normal para nosotros? Sí, me ayudó a escribir unos mails y reportes, pero yo necesitaba decirle «mándame un reporte o análisis de la situación competitiva de tal empresa o un análisis financiero de tal cosa» y me respondía que no estaba para eso todavía.34

Sin embargo, hasta los más escépticos están interesados en entender cómo funciona y qué se puede hacer con esta versión avanzada de ia. En palabras de un gerente regional de una empresa multinacional que vende servicios de Google, principalmente en Europa, y que en la práctica funciona como departamento de ventas tercerizado, «no es algo que necesitemos tener ya, aunque sí se percibió un cambio y es monumental lo que está pasando con Chatgpt»35.

Sin dudas, lo que está pasando es monumental porque asistimos, a escala global, a un proceso acelerado de reemplazo no solo de tareas sino también de procesos de aprendizaje humano. Y esta transición, a menos que cambie el modo en que se produce la ia, se profundiza a medida que avanza su adopción. Una investigación de la Comisión Europea, publicada varios años antes del lanzamiento de Chatgpt, encontró que allí donde se introdujo ia, la autonomía en el lugar de trabajo se redujo, se siente una pérdida de control sobre el proceso de producción, aumentó el ritmo de trabajo y las trabajadoras y trabajadores se sienten privados de usar su inteligencia en el espacio laboral. Todo esto contribuye, además, a un debilitamiento de las capacidades de lucha de los sindicatos, en la medida en que hay menor conocimiento sobre el lugar de trabajo y el proceso productivo36.

Esa sensación de achicamiento del espacio en el cual se promueve el desarrollo de la inteligencia humana no es consecuencia de la ia en general, sino del tipo de ia que se produce. Son cajas negras, las usamos casi sin tener idea de cómo funcionan. Incluso si pudiéramos leer parte del código, como en el caso de los modelos de código abierto, una abrumadora mayoría de las personas seguiría sin ser capaz de entender qué dicen y hacen esos algoritmos. ¿Qué espacio queda para el aprendizaje humano cuando las condiciones de uso vienen predefinidas por unas pocas empresas que ofrecen tecnología a caja cerrada? Aunque aflore la creatividad acerca de qué tipo de preguntas hacerle a un llm, en última instancia el tipo de respuesta y los usos posibles quedan limitados por cómo fue entrenado –con qué datos– y por los parámetros considerados en el modelo. Y todo esto es decidido en secreto por un puñado de empresas.

La división del trabajo informático dentro de las grandes empresas tecnológicas contribuye más aún a compartimentar el conocimiento y fomentar la hiperespecialización. Las políticas impuestas dentro de estas empresas y en relación con el exterior limitan el intercambio de información y conocimientos hasta el punto de que probablemente nadie que conozca líneas de código fundamentales tenga una visión global o generalista de la ia de frontera. Esta visión global queda en manos de gerentes que desconocen –probablemente eligen desconocer– los detalles acerca de cómo funciona cada algoritmo. Un investigador en ia de ibm lo resumió diciendo que «te enseñan a no compartir los detalles de cada proyecto con quienes no tienen ‘necesidad de saberlo’; es una norma básica de ibm»37.

En cierta medida, lo que observamos es un nuevo ciclo, con sus especificidades, de un proceso de pérdida de habilidades en el espacio de trabajo que lleva más de un siglo. Harry Braverman lo describió minuciosamente dando cuenta de cómo se reconfiguró la relación entre el trabajador, por un lado, y la máquina y el directivo, por otro. La máquina reemplazó tareas estandarizadas y esa estandarización, el proceso de convertir el conocimiento tácito en protocolos explícitos, redujo el conocimiento local basado en la experiencia y convirtió los puestos de trabajo en secuencias de tareas simples. Los managers dirigen ejerciendo un «monopolio sobre el conocimiento para controlar cada paso del proceso laboral y su modo de ejecución»38.

El ciclo actual es más complejo. La reorganización descrita por Braverman tuvo lugar dentro de todas y cada una de las fábricas, mientras que hoy asistimos a una reorganización del trabajo y del aprendizaje entre empresas. La máquina no solo «aprende» a expensas de trabajadores que interactúan directamente con ella, sino también a expensas de la capacidad de aprendizaje de la mayoría de las organizaciones –de sus trabajadores– y, en última instancia, de las sociedades. Menuda paradoja siendo que se supone que vivimos en la «sociedad del conocimiento».

Más allá de los efectos económicos, entre otros en materia de mayores desigualdades, este proceso está ampliando las brechas entre quienes saben y quienes ignoran. Pero esta no es la única forma posible de desarrollar e interactuar con las tecnologías digitales. Esta es la forma privada y con fines de lucro.

¿Progreso?

El debate político actual gira en torno de la agencia de la ia. Los ceo de las big tech y Openai encabezan la lista de quienes abogan por regular cómo se usa esta tecnología39. Al centrar el debate en la regulación de su adopción, desvían la atención de otro ámbito que debiera ser tanto o más regulado: el proceso de producción de ia, aquel que estas empresas controlan. En otras palabras, un excesivo foco en la agencia de la ia corre el riesgo de pasar por alto el papel de los agentes que controlan la ia.

Los enfoques y discursos de estos ceo y los artículos académicos de sus empresas también determinan cómo pensamos la ia. La presentan como una tecnología que sustituye (e incluso supera) a la inteligencia humana, no como una forma diferente y complementaria de resolver problemas que siempre se alimenta y es resultado del trabajo humano. ¿Por qué no concebir y producir ia como si fuera una grúa de construcción? Con una grúa podemos levantar más peso que con nuestra propia fuerza. La grúa reemplazó tareas, pero no limitó nuestra capacidad de desarrollo y aprendizaje. Para ello, hace falta que el conocimiento asociado a la ia se vuelva público, lo cual requiere educación digital para que podamos entender cómo funcionan estos algoritmos.

La automatización de ciertos puestos de trabajo o tareas que requieren niveles de capacitación mucho mayores que los necesarios para levantar una grúa –y con ello, la pérdida de capacidades de aprendizaje asociadas– no es un resultado inevitable. Es producto de una decisión económica y política de privilegiar una ia que reemplaza en lugar de potenciar. Probablemente sea una estrategia de venta más exitosa que la de potenciar una ia de complemento, que en principio podría parecer más costosa, lo que pone de relieve la necesidad de producir soluciones públicas y sin fines de lucro, en la medida en que toda empresa privada que produzca ia de frontera buscará rentabilizar su producto desarrollándolo de tal modo que maximice su acumulación.

Es imperioso y necesario discutir qué tipo de ia se codifica, quién la codifica y cómo se reparten sus beneficios. Es urgente debatir democráticamente qué ia queremos como sociedad y para qué. Este debate es indisociable de la pregunta sobre qué datos han de ser recopilados –y cuáles no– y cómo se decidirá quién accede y cómo a las bases resultantes.

La urgencia por debatir el presente del trabajo ofrece además un escenario propicio para presionar en pos de mejores condiciones laborales, en una época en la cual la contracara de más tecnología representa la potencial dilución del trabajo registrado bajo figuras como la del emprendedor supuestamente independiente de las plataformas; lo que en los hechos es una persona gobernada por algoritmos y tan precarizada que hasta debe invertir en sus medios de producción (la bicicleta para el reparto a domicilio, el auto para el transporte de pasajeros, etc.). ¿Por qué no hacer de la desgracia virtud y usar esta oportunidad para debatir acerca del trabajo en general, replantearnos cómo trabajamos y prefigurar alternativas?

-

1.

Krystal Hu: «ChatGTP Sets Record for Fastest-Growing User Base: Analyst Note» en Reuters, 2/2/2023.

-

2.

Para un análisis detallado de cómo esta y otras consultoras ganan dinero infantilizando y volviendo estructuralmente dependientes a sus clientes, v. Mariana Mazzucato y Rosie Collington: The Big Con: How the Consulting Industry Weakens Our Businesses, Infantilizes Our Governments, and Warps Our Economies, Penguin, Londres, 2023.

-

3.

Kweilin Ellingrud, Saurabh Sanghvi, Gurneet Singh Dandona, Anu Madgavkar, Michael Chui, Olivia White y Paige Hasebe: «Generative AI and the Future of Work in America», McKinsey Global Institute, 26/7/2023.

-

4.

Organización Mundial de la Propiedad Intelectual (OMPI): Tendencias de la tecnología 2019 – Inteligencia artificial, 2019.

-

5.

Md Zahangir Alom et al.: «The History Began from Alexnet: A Comprehensive Survey on Deep Learning Approaches» en ArXiv, 2018.

-

6.

Stefano Bianchini, Moritz Müller y Pierre Pelletier: «Artificial Intelligence in Science: An Emerging General Method of Invention» en Research Policy vol. 51 No 10, 2022; C. Rikap y Bengt-Åke Lundvall: The Digital Innovation Race: Conceptualizing the Emerging New World Order, Palgrave Macmillan, Londres, 2021; Iain M. Cockburn, Rebecca Henderson y Scott Stern: The Impact of Artificial Intelligence on Innovation, National Bureau of Economic Research, 2018; Avi Goldfarb, Bledi Taska y Florenta Teodoridis: «Could Machine Learning Be a General Purpose Technology? A Comparison of Emerging Technologies Using Data from Online Job Postings» en Research Policy vol. 52 No 1, 2023.

-

7.

Eben Carle: «Ask a Techspert: What is Generative AI?» en blog de Google, 11/4/2023.

-

8.

Esta definición proviene de una entrevista realizada por mí (2/2023). Hago referencia en este artículo a parte de las entrevistas que estoy llevando adelante con motivo de mi nuevo libro. Se trata de un conjunto de, actualmente, más de 50 entrevistas en profundidad semiestructuradas acerca de la producción y el uso de tecnologías digitales por parte de 60 grandes empresas multinacionales, entre las cuales incluí a las gigantes digitales –big tech– de EEUU y China.

-

9.

Eugene Kim: «Amazon Warns Employees Not to Share Confidential Information with ChatGTP after Seeing Cases Where Its Answer ‘Closely Matches Existing Material’ from Inside the Company» en Insider, 24/1/2023.

-

10.

«Our Early-Adopters Index Examines How Corporate America is Deploying AI» en The Economist, 25/1/2023.

-

11.

«Microsoft CEO on AI Race: ‘Not a Given’ that Alphabet or Microsoft are the Only Two Games in Town» en CNBC, 16/5/2023.

-

12.

«Microsoft and OpenAI Extend Partnership» en blog de Microsoft, disponible en https://blogs.microsoft.com/blog/2023/01/23/microsoftandopenaiextendpartnership/.

-

13.

John Roach: «How Microsoft’s Bet on Azure Unlocked an AI Revolution» en News Microsoft, 13/3/2023.

-

14.

Lauren Leffer: «Zuckerberg Introduces Meta’s Answer to ChatGPT, llama» en Gizmodo, 24/2/2023.

-

15.

Dina Bass: «Amazon Enters Chatbot Wars with AI Startup Partnership» en Los Angeles Times, 21/2/2023; Amazon Staff: «AWS Announces Amazon Bedrock and Multiple Generative AI Services and Capabilities» en Amazon News, 13/4/2023.

-

16.

Marco Iansiti y Karim R. Lakhani: «Managing Our Hub Economy» en Harvard Business Review, 9-10/2017, p. 87.

-

17.

C. Rikap: «Same End by Different Means: Google, Amazon, Microsoft and Facebook’s Strategies to Dominate Artificial Intelligence», Cityperc Working Paper Series, 2023.

-

18.

V. evidencia empírica de esta apropiación en C. Rikap y B. Lundvall: ob. cit.

-

19.

V. estadísticas en https://github.com/sanagno/neurips_2022_statistics.

-

20.

C. Rikap: Capitalism, Power and Innovation. Intellectual Monopoly Capitalism Uncovered, Routledge, Londres, 2021.

-

21.

Tung-Hui Hu: A Prehistory of the Cloud, MIT Press, Cambridge, 2015, p. xii.

-

22.

Entrevista con la autora, 3/2023.

-

23.

Entrevista con la autora, 6/2022.

-

24.

Entrevista con la autora, 5/2023.

-

25.

R. Jurowetzki, Daniel Hain, Juan Mateos-Garcia y Konstantinos Stathoulopoulos: «The Privatization of AI Research(-ers): Causes and Potential Consequences – From University-Industry Interaction to Public Research Brain-Drain?» en ArXiv, 2021.

-

26.

M. Gofman y Zhao Jin: «Artificial Intelligence, Education, and Entrepreneurship» en Journal of Finance, 7/2022.

-

27.

C. Rikap: «Same End by Different Means», cit.

-

28.

Kate Crawford: The Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence, Yale UP, New Haven, 2021. [Hay edición en español: Atlas de inteligencia artificial. Poder, política y costos planetarios, FCE, Buenos Aires, 2022].

-

29.

Janine Berg, Marianne Furrer, Ellie Harmon, Uma Rani y M. Six Silberman: «Digital Labour Platforms and the Future of Work» en Towards Decent Work in the Online World, OIT, 2018.

-

30.

Ver Qayyah Moynihan y Laura Martínez: «Execution Videos, Sex in the Office, ptsd and isis Sing-Alongs: A Day in the Life of an Online Content Moderator» en Insider, 6/3/2020; Casey Newton: «The Trauma Floor: The Secret Lives of Facebook Moderators in America» en The Verge, 25/2/2019.

-

31.

Entrevista con la autora, 9/2023.

-

32.

Entrevista con la autora, 4/2023.

-

33.

Uno de los artículos más citados en la materia es Daron Acemoğlu y Pascual Restrepo: «Robots and Jobs: Evidence from us Labor Markets» en Journal of Political Economy vol. 128 No 6, 2020.

-

34.

Entrevista con la autora, 8/2023.

-

35.

Entrevista con la autora, 3/2023.

-

36.

Comisión Europea, Agencia Ejecutiva para las Pequeñas y Medianas Empresas (EASME): «Artificial Intelligence: Critical Industrial Applications: Report on Market Analysis of Prioritised Value Chains, the Most Critical AI Applications and the Conditions for AI Rollout», 2020, disponible en data.europa.eu/doi/10.2826/838431.

-

37.

Entrevista con la autora, 3/2023.

-

38.

H. Braverman: Labor and Monopoly Capital: The Degradation of Work in the Twentieth Century, NYU Press, Nueva York, 1998, p. 82.

-

39.

Prarthana Prakash: «OpenAI’s Sam Altman and Google’s Sundar Pichai are Now Begging Governments to Regulate the AI Forces They’ve Unleashed» en Fortune, 23/5/2023.